|

Когда исследователи попросили чатбот назначить лечение, то правильные и неправильные рекомендации смешивались в трети ответов, что затрудняло выявление ошибок. Для многих пациентов Интернет служит мощным инструментом самообразования по медицинским вопросам. Поскольку ChatGPT теперь находится у пациентов под рукой, исследователи из больницы Brigham and Women's Hospital, являющейся одним из основателей системы здравоохранения Mass General Brigham, проанализировали, насколько последовательно чат-бот с искусственным интеллектом дает рекомендации по лечению рака, соответствующие рекомендациям Национальной комплексной онкологической сети (National Comprehensive Cancer Network, NCCN). Результаты исследования, опубликованные в журнале JAMA Oncology, свидетельствуют о том, что примерно в трети случаев ChatGPT 3.5 давал неадекватные ( «несогласованные») рекомендации, что подчеркивает необходимость информирования пациентов об ограничениях этой технологии.

Появление инструментов искусственного интеллекта в здравоохранении стало революционным и способно позитивно изменить весь процесс оказания медицинской помощи. Mass General Brigham, являясь одной из ведущих интегрированных академических систем здравоохранения и крупнейшим инновационным предприятием страны, играет ведущую роль в проведении тщательных исследований новых и новейших технологий, чтобы обеспечить ответственное внедрение искусственного интеллекта в оказание медицинской помощи, поддержку персонала и административные процессы. Хотя на принятие врачебных решений может влиять множество факторов, Биттерман и его коллеги решили оценить, насколько рекомендации ChatGPT соответствуют рекомендациям NCCN, которые используются врачами в учреждениях по всей стране. Они сосредоточили внимание на трех наиболее распространенных видах рака (рак молочной железы, рак простаты и рак легкого) и предложили ChatGPT предложить подход к лечению каждого вида рака в зависимости от степени тяжести заболевания. В общей сложности исследователи включили 26 уникальных описаний диагнозов и использовали четыре несколько отличающихся друг от друга запроса к ChatGPT о подходе к лечению, в результате чего было получено 104 запроса. Почти все ответы (98%) включали по крайней мере один подход к лечению, согласующийся с рекомендациями NCCN. Однако 34% ответов содержали также одну или несколько несогласованных рекомендаций, которые иногда было трудно обнаружить на фоне других рекомендаций. Под несогласованными рекомендациями понимались те, которые были верны лишь частично; например, при местно-распространенном раке молочной железы рекомендовалось только хирургическое вмешательство без упоминания других методов лечения. Примечательно, что полное согласие в оценках имело место только в 62% случаев, что свидетельствует как о сложности самих рекомендаций NCCN, так и о том, что результаты работы ChatGPT могут быть нечеткими или сложными для интерпретации. В 12,5% случаев ChatGPT выдавал «галлюцинации», или рекомендации по лечению, полностью отсутствующие в рекомендациях NCCN. К ним относились рекомендации по применению новых методов лечения или лечебной терапии при некурабельных формах рака. Авторы подчеркнули, что такая форма дезинформации может неверно формировать ожидания пациентов в отношении лечения и потенциально влиять на взаимоотношения между врачом и пациентом. В дальнейшем исследователи изучают, насколько хорошо пациенты и врачи могут отличить медицинские рекомендации, написанные врачом, от большой языковой модели, подобной ChatGPT. Кроме того, для дальнейшей оценки клинических знаний ChatGPT они предлагают более подробные клинические случаи. Авторы использовали GPT-3.5-turbo-0301, одну из самых больших моделей, доступных на момент проведения исследования, и класс моделей, который в настоящее время используется в открытой версии ChatGPT (более новая версия, GPT-4, доступна только при платной подписке). Также использовались рекомендации NCCN от 2021 года, поскольку GPT-3.5-turbo-0301 был разработан на основе данных до сентября 2021 года. Хотя результаты могут отличаться при использовании других моделей и/или клинических рекомендаций, исследователи подчеркивают, что многие языковые модели схожи по способу построения и ограничениям, которыми они обладают.

24.08.2023 |

Net&IT

| |

| Учёные ЛЭТИ создали прототип системы для прогноза осадков и диагностики фруктов | |

Прототип интеллектуальной системы в будущ... | |

| |

| Казанский студент намерен разработать умные очки в 3 раза дешевле аналогов | |

Осман Ширгалин, студент 2 курса Института вычи... | |

| |

| Прекратите гуглить и поспите днем, чтобы снизить риск деменции | |

Канадский учёный Мохамед И. Элмасри считает, ч... | |

| |

| AIChE Journal: Инженеры исследуют расширение интеллекта для большей безопасности | |

В последние годы искусственный интеллект стал ... | |

| |

| Эффективность светодиодов для дополненной реальности выросла вдвое | |

Учёные из России и Кореи усовершенст... | |

| |

| App.System Innovation: Управлять умными колонками оказалось слишком сложно | |

Благодаря удобству и возможности управлят... | |

| |

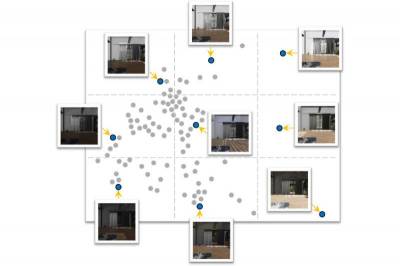

| Patterns: Детский зрительный опыт поможет усовершенствовать компьютерное зрение | |

Новый подход к обучению систем искусствен... | |

| |

| ИИ-платформа для анализа изображений поможет развивать исследования во всем мире | |

Группа исследователей из Института Гульбе... | |

| |

| Инженеры воссоздали голопалубу Star Trek с помощью ChatGPT и видеоигр | |

В сериале Звездный путь: Следующее поколение к... | |

| |

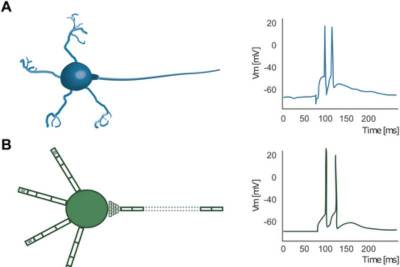

| IC: Исследователи тестируют биологическую безвредность нейроморфной сети | |

Биологический мозг, в особенности человеч... | |

| |

| Science: Аналоговые вычисления дают решать сложные уравнения и экономят энергию | |

Группа исследователей, включая инженеров Масса... | |

| |

| В 40% случаев люди ошибочно называют сгенерированное фото человека реальным | |

Если вам недавно было трудно понять, явля... | |

| |

| Physical Review X: Сеть квантовых датчиков повышает точность измерений | |

Квантовые системы, используемые в квантов... | |

| |

| Scientific Reports: ИИ показал больший творческий потенциал, чем человек | |

Еще один балл в пользу искусственного инт... | |

| |

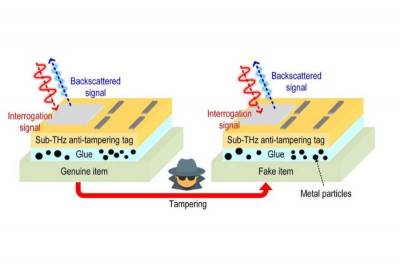

| Крошечную метку на замену RFID сделали еще надежнее | |

Несколько лет назад исследователи Массачу... | |

| |

| Привыкнув доверять, люди не поймут, когда ИИ начнет манипулировать | |

Согласно обширному обзору, в настоящее вр... | |

| |

| Умные серьги с низким энергопотреблением будут измерять температуру по мочке уха | |

Умные аксессуары становятся все более рас... | |

| |

| Для борьбы с бешенством разработали приложение для распознавания собачьих морд | |

Новое приложение для распознавания собачь... | |

| |

| Генеративный ИИ помогает ученым объяснить человеческую память и воображение | |

Последние достижения в области генеративн... | |

| |

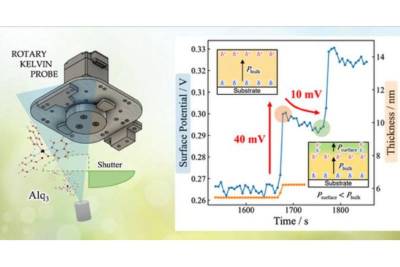

| Ученые приблизились к более легким и гибким оптоэлектронным устройствам | |

Органические оптоэлектронные устройства, такие... | |

| |

| ChatGPT перелопатил почти весь интернет, но пока не научился рассуждать | |

Языковые модели ИИ переживают бум. В ... | |

| |

| Если сотрудникам скорой помощи поможет ИИ, они смогут спасать больше жизней | |

Чтобы определить, насколько серьезно пострадал... | |

| |

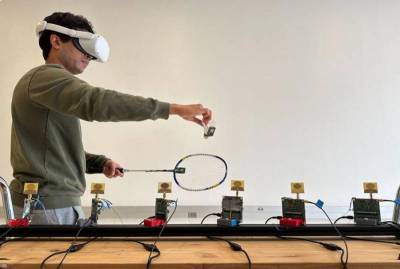

| Беспроводная система отслеживания улучшит впечатления от расширенной реальности | |

Новая технология, разработанная инженерами Кал... | |

| |

| PNAS Nexus: ИИ пока еще далеко до человеческих способностей мыслить | |

Атанасиос С. Фокас рассматривает актуальный во... | |

| |

| Nature: ИИ генерирует белки с исключительной прочностью связывания | |

В новом исследовании, опубликованном 18 декабр... | |

| |

| Nature Computational Science: ИИ может предсказывать события в жизни людей | |

Искусственный интеллект, разработанный для&nbs... | |

| |

| Разработан фреймворк ИИ для определения новых показаний к применению лекарств | |

Ученые из компании Klick Applied Sciences... | |

| |

| Искусственный интеллект отлично справляется с имитацией, но не с инновациями | |

Системы искусственного интеллекта часто изобра... | |

| |

| Nature Electronics: Изменение памяти дает новые вычислительные возможности | |

Ученые Рочестерского университета разработали ... | |

| |

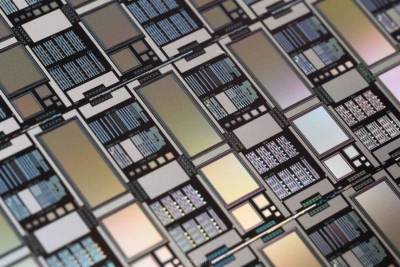

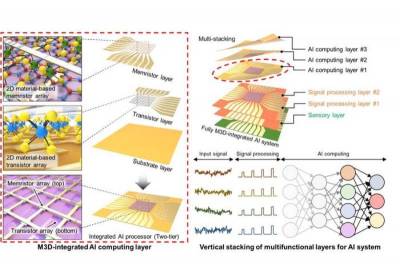

| Nature: 2D-материал изменяет форму 3D-электроники для искусственного интеллекта | |

Многофункциональные компьютерные чипы эволюцио... | |